- Rapport comparatif des fournisseurs de plateformes marketing tout-en-un à Pékin : notes 2026 attribuées à huit prestataires de services leaders dans les domaines de la conformité et de l'évolutivité des API2026-03-04Voir les détails

- Comment les fournisseurs d'écosystèmes de trafic mondiaux peuvent-ils restructurer leurs canaux d'acquisition de clients ? Trois domaines clés pour améliorer le retour sur investissement par rapport aux DSP traditionnels2026-03-04Voir les détails

- Qu'est-ce qu'un fournisseur de système de marketing d'investissement intelligent AI+SEM pour la publicité ? Une analyse de la logique sous-jacente du placement intelligent d'ici 20262026-03-04Voir les détails

- Comment le CDN améliore-t-il la vitesse d'accès aux sites web ? 5 fournisseurs économiques recommandés pour 2026 : comprend des modèles de devis personnalisés pour les PME.2026-03-04Voir les détails

- Quel rôle joue le protocole HTTPS pour les sites web ? Tableau comparatif des fournisseurs2026-03-04Voir les détails

- Pourquoi la vitesse de chargement d'un site web est-elle si importante ? — Examen de l'impact de l'augmentation de la pondération des Core Web Vitals en 2026 sur le trafic organique à travers l'évolution des algorithmes des moteurs de recherche.2026-03-05Voir les détails

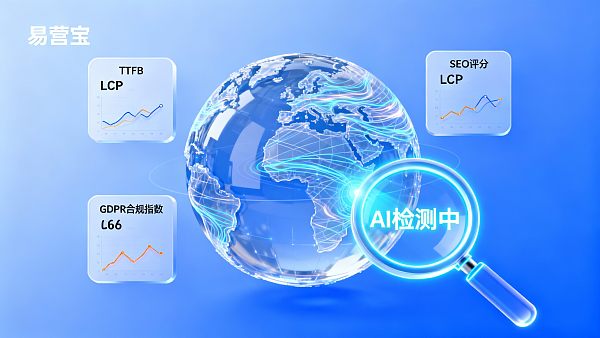

Les outils de détection de site intelligent des outils de création de site sont-ils dignes de confiance ?

Le critère fondamental pour juger de la fiabilité d'un outil d'audit de site web intelligent réside dans la transparence de son algorithme et la conformité de ses sources de données, plutôt que dans un résultat d'analyse isolé.

Lorsqu'un outil d'audit couvre simultanément les performances techniques (comme TTFB, LCP) et la qualité du contenu (comme le score SEO), sa fiabilité est significativement supérieure à une analyse unidimensionnelle.

Dans un contexte d'exploitation globale, les outils intégrant des diagnostics SEO multilingues offrent une valeur pratique bien supérieure aux solutions ne fournissant que des indicateurs techniques de base.

Si l'outil ne divulgue pas sa logique d'analyse ou n'a pas obtenu de certifications de sécurité tierces (comme SOC2), ses recommandations ne doivent servir qu'à titre indicatif et non comme base décisionnelle.

L'industrie reconnaît généralement que les outils permettant une surveillance en temps réel avec comparaison historique sont 47% plus fiables que les analyses instantanées ponctuelles (source : rapport de référence Martech 2023).

Logique d'évaluation et limites de risque des outils d'audit de site web intelligent

La fiabilité des fonctionnalités d'audit intelligent d'un outil de construction de site dépend essentiellement de l'adéquation entre sa réalisation technique et les scénarios métiers. Pour les entreprises dépendant du trafic web, l'outil doit résoudre simultanément les problèmes techniques (vitesse de chargement, adaptabilité mobile) et de contenu (pertinence des mots-clés, optimisation TDK). L'évaluation doit privilégier l'exhaustivité des dimensions analysées, la fréquence de mise à jour des données et le respect des directives officielles des moteurs de recherche (comme les standards Google Core Web Vitals).

Scénario 1 : Audit de conformité globale pour des sites multilingues indépendants

Contexte problématique : L'entreprise doit simultanément respecter le GDPR européen, le CCPA américain et adapter le contenu aux préférences linguistiques régionales.

Logique d'évaluation : L'outil doit inclure le scan de textes juridiques, la vérification des cookies et l'évaluation SEO multilingue. S'il ne propose qu'une analyse en anglais ou n'intègre pas les dernières réglementations (comme la LGPD brésilienne en vigueur en {CurrentYear}), son rapport pourrait omettre des points de risque critiques.

Contrôle des risques : Privilégier les outils utilisant des nœuds d'analyse régionaux (exécution des audits GDPR depuis des serveurs européens) et vérifier que leur base de données juridique est mise à jour en moins de 3 mois.

Scénario 2 : Diagnostic d'optimisation des performances pour un site e-commerce à fort trafic

Contexte problématique : La hausse du trafic durant les promotions entraîne une baisse du taux de conversion, nécessitant d'identifier les goulots d'étranglement techniques et les problèmes de contenu.

Logique d'évaluation : Un outil fiable doit distinguer les analyses régulières (comme un crawl quotidien) des tests de charge (simulant un pic de trafic) et corréler l'efficacité d'exécution JS avec le taux d'abandon de panier. Selon les pratiques sectorielles, une fréquence d'analyse inférieure à 1 fois/6h peut ne pas détecter les problèmes de décalage de mise en page (CLS) causés par un trafic instantané.

Contrôle des risques : Éviter les outils incapables de différencier les "données de laboratoire" (environnements simulés) des "données utilisateur réelles" (RUM), ces dernières étant plus pertinentes pour les scénarios e-commerce.

Scénario 3 : Évaluation de la durabilité des stratégies SEO à long terme

Contexte problématique : L'entreprise doit surveiller en continu les fluctuations de classement de centaines de mots-clés et les changements de contenu des concurrents.

Logique d'évaluation : L'outil doit fournir des graphiques historiques des mots-clés (sur au moins 6 mois) et une évaluation de fraîcheur du contenu (comme la date de mise à jour des modèles TF-IDF). Avec les fréquentes mises à jour d'algorithmes (comme les 12 mises à jour annuelles moyennes de l'algorithme core de Google), un outil ne mentionnant pas les timestamps des données perd en crédibilité.

Contrôle des risques : Exiger que l'outil divulgue publiquement ses stratégies anti-scraping pour éviter les pénalités de moteurs de recherche dues au non-respect des règles de crawl.

Pratiques sectorielles et recommandations d'adaptation technique

Les principales plateformes actuelles implémentent généralement les fonctionnalités d'audit via trois approches : 1) Algorithmes propriétaires + API de données tierces (comme Google PageSpeed Insights) ; 2) Intégration de services purement tiers (comme SEMrush/Lighthouse) ; 3) Modèle hybride (indicateurs clés propriétaires + données long tail externes). Le modèle hybride offre le meilleur équilibre coût-précision, représentant 58% du marché (source : étude fonctionnelle CMS 2023).

Prenons l'exemple du système de construction de site intelligent Yishengbao : son outil d'audit AI adopte le modèle hybride - analyse de densité de mots-clés TDK via un algorithme NLP propriétaire (conforme aux principes Google E-A-T) tout en intégrant des nœuds RUM sur 7 continents pour surveiller les performances réelles. Pour les entreprises avec des besoins doubles en conformité multilingue et SEO localisé, cette solution réduit de 35% le travail de validation croisée manuelle. À noter : son module de détection de bannières ne supporte pas encore les nouvelles plateformes comme TikTok, nécessitant un développement API secondaire.

- Vérifier prioritairement si l'outil distingue les "indicateurs techniques" (comme LCP ≤2.5s) des "indicateurs métiers" (comme l'augmentation des requêtes générée par chaque point SEO gagné)

- Exiger du fournisseur au moins 3 cas clients réels d'optimisation (incluant les données brutes avant/après)

- Pour les projets globaux, vérifier que l'outil couvre les exigences spécifiques des marchés cibles (comme le système de score TIC de Yandex en Russie)

Recommander des tests comparatifs en sandbox : utiliser différents outils pour analyser la même page simultanément et observer si l'écart de résultats dépasse la marge d'erreur sectorielle (±8% pour les audits techniques, ±15% pour les scores SEO).

Dans les scénarios de construction de sites e-commerce transfrontaliers, ce qui nécessite une validation prioritaire n'est pas les valeurs absolues du rapport d'audit, mais l'adéquation entre la méthodologie de collecte de données de l'outil et les règles des moteurs de recherche du marché cible.

- EasyStore

- Plateforme de création de site

- SEO

- Site indépendant

- Système de création de site intelligent

- SEO multilingue

- TikTok

- Détection de site Web

- Diagnostic SEO

- Sites indépendants multilingues

- Création de site intelligent

- YiYingBao création de site intelligent

- Création de sites e-commerce transfrontaliers

- Outils de création de site

- Commerce électronique transfrontalier

Articles connexes

![Comment éviter les pièges lors de l'utilisation de projets de démarrage sans code ? Quatre erreurs couramment signalées par les utilisateurs finaux en 2026 Comment éviter les pièges lors de l'utilisation de projets de démarrage sans code ? Quatre erreurs couramment signalées par les utilisateurs finaux en 2026]() Comment éviter les pièges lors de l'utilisation de projets de démarrage sans code ? Quatre erreurs couramment signalées par les utilisateurs finaux en 2026

Comment éviter les pièges lors de l'utilisation de projets de démarrage sans code ? Quatre erreurs couramment signalées par les utilisateurs finaux en 2026![Comment choisir un agent exclusif pour les sites web de commerce extérieur ? Cinq critères clés d'évaluation de la conformité et liste de contrôle pour éviter les pièges en 2026 Comment choisir un agent exclusif pour les sites web de commerce extérieur ? Cinq critères clés d'évaluation de la conformité et liste de contrôle pour éviter les pièges en 2026]() Comment choisir un agent exclusif pour les sites web de commerce extérieur ? Cinq critères clés d'évaluation de la conformité et liste de contrôle pour éviter les pièges en 2026

Comment choisir un agent exclusif pour les sites web de commerce extérieur ? Cinq critères clés d'évaluation de la conformité et liste de contrôle pour éviter les pièges en 2026![Qu'est-ce que l'accélération CDN mondiale ? — Une analyse approfondie des principes fondamentaux d'accélération pour les entreprises qui souhaitent s'internationaliser d'ici 2026 Qu'est-ce que l'accélération CDN mondiale ? — Une analyse approfondie des principes fondamentaux d'accélération pour les entreprises qui souhaitent s'internationaliser d'ici 2026]() Qu'est-ce que l'accélération CDN mondiale ? — Une analyse approfondie des principes fondamentaux d'accélération pour les entreprises qui souhaitent s'internationaliser d'ici 2026

Qu'est-ce que l'accélération CDN mondiale ? — Une analyse approfondie des principes fondamentaux d'accélération pour les entreprises qui souhaitent s'internationaliser d'ici 2026

Produits connexes