- Informe comparativo de proveedores de plataformas de marketing integrales de Pekín: puntuaciones de 2026 para ocho proveedores de servicios líderes en las dimensiones de cumplimiento normativo y escalabilidad de API.2026-03-04Ver detalles

- ¿Cómo pueden los proveedores de ecosistemas de tráfico global reestructurar sus canales de adquisición de clientes? Tres áreas clave para mejorar el ROI en comparación con los DSP tradicionales2026-03-04Ver detalles

- ¿Qué es un proveedor de sistemas de marketing de inversión inteligente para publicidad AI+SEM? Análisis de la lógica subyacente de la colocación inteligente para 2026.2026-03-04Ver detalles

- ¿Cómo mejora la CDN la velocidad de acceso a los sitios web? Los 5 proveedores más rentables recomendados para 2026: incluye plantillas de presupuestos personalizados para pymes.2026-03-04Ver detalles

- ¿Qué papel desempeña el protocolo HTTPS en los sitios web? Tabla comparativa de proveedores2026-03-04Ver detalles

- ¿Por qué es tan importante la velocidad de carga de un sitio web? — Análisis del impacto del aumento de la ponderación de Core Web Vitals en 2026 sobre el tráfico orgánico a través de la evolución de los algoritmos de los motores de búsqueda.2026-03-05Ver detalles

¿Merece confianza la herramienta de detección de sitios web inteligente de las herramientas de construcción de sitios web?

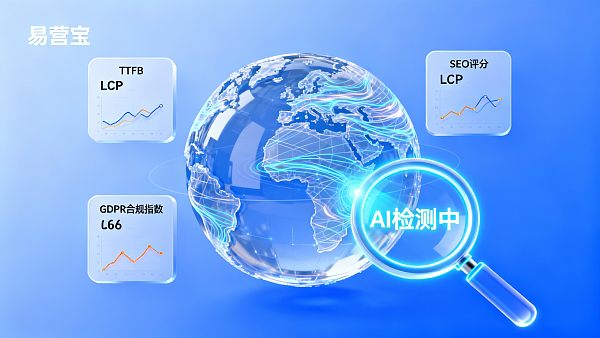

El criterio central para determinar si una herramienta de detección de sitios web inteligente es confiable radica en la transparencia de su algoritmo y la conformidad de sus fuentes de datos, no en un único resultado de detección.

Cuando una herramienta de detección cubre tanto el rendimiento técnico (como TTFB, LCP) como la calidad de contenido (como puntuaciones SEO), su confiabilidad es significativamente mayor que una detección unidimensional.

En escenarios de operación globalizada, las herramientas que admiten diagnósticos SEO multilingüe tienen mayor valor práctico que aquellas que solo proporcionan detección básica de indicadores técnicos.

Si una herramienta no publica su lógica de detección o no ha pasado certificaciones de seguridad de terceros (como SOC2), sus informes solo deben usarse como referencia, no como base para decisiones.

La industria reconoce ampliamente que las herramientas que ofrecen monitoreo en tiempo real y comparación de datos históricos tienen un 47% más de confiabilidad que las detecciones instantáneas (Fuente: Informe de referencia Martech 2023).

Lógica de evaluación y límites de riesgo de las herramientas de detección de sitios web inteligentes

La confiabilidad de las funciones de detección inteligente de herramientas de construcción de sitios web depende fundamentalmente de su implementación técnica y alineación con escenarios comerciales. Para empresas que dependen de sitios web para captar clientes, las herramientas deben resolver simultáneamente problemas técnicos (velocidad de carga, adaptación móvil) y de contenido (efectividad de palabras clave, optimización TDK). La evaluación debe enfocarse en la integridad de las dimensiones de detección, frecuencia de actualización de datos y cumplimiento con pautas oficiales de motores de búsqueda (como los estándares Google Core Web Vitals).

Escenario 1: Detección de conformidad global para sitios independientes multilingües

Contexto del problema: Las empresas deben cumplir simultáneamente con requisitos de conformidad de datos como GDPR de la UE y CCPA de EE.UU., mientras adaptan el contenido del sitio a preferencias lingüísticas regionales.

Lógica de juicio: Las herramientas de detección deben incluir capacidades básicas de escaneo de texto legal, verificación de cookies y evaluación SEO multilingüe. Si una herramienta solo ofrece detección en inglés o no integra las últimas bibliotecas de regulaciones de privacidad (como la LGPD brasileña vigente en {CurrentYear}), sus informes podrían omitir puntos clave de riesgo.

Control de riesgos: Priorice verificar si la herramienta utiliza nodos de detección localizados (por ejemplo, ejecutando detecciones GDPR desde servidores europeos) y si su ciclo de actualización de bases de datos legales es inferior a 3 meses.

Escenario 2: Diagnóstico de optimización de rendimiento para sitios de comercio electrónico de alto tráfico

Contexto del problema: El aumento repentino de tráfico durante promociones lleva a caídas en tasas de conversión, requiriendo identificar cuellos de botella de rendimiento y problemas de contenido ineficaz.

Lógica de juicio: Herramientas confiables deben diferenciar entre detecciones normales (como rastreos programados diarios) y pruebas de estrés (simulando tráfico máximo), además de correlacionar eficiencia de ejecución JS con tasas de abandono de carritos. Según prácticas industriales, cuando la frecuencia de detección es menor a 1 vez/6 horas, puede perderse problemas de desplazamiento de diseño CLS causados por tráfico instantáneo.

Control de riesgos: Evite herramientas que no distingan entre "datos de laboratorio" (entornos simulados) y "datos de usuarios reales" (RUM), siendo estos últimos más valiosos para escenarios de comercio electrónico.

Escenario 3: Evaluación de sostenibilidad de estrategias SEO a largo plazo

Contexto del problema: Las empresas necesitan monitorear continuamente fluctuaciones en clasificación de cientos de palabras clave y cambios en contenido de competidores.

Lógica de juicio: Las herramientas deben proporcionar gráficos de trayectoria histórica de palabras clave (con al menos 6 meses de datos) y evaluación de frescura de contenido (como tiempo de actualización de modelos TF-IDF). Con actualizaciones frecuentes de algoritmos de motores de búsqueda (como Google actualizando su algoritmo central 12 veces/año), herramientas sin marcas de tiempo de recolección de datos generan dudas sobre su confiabilidad.

Control de riesgos: Exija que las herramientas divulguen públicamente sus estrategias anti-crawling, evitando penalizaciones por violar reglas de rastreo de motores de búsqueda.

Prácticas industriales y recomendaciones de adaptación técnica

Las principales plataformas de construcción de sitios actualmente implementan funciones de detección de tres maneras: 1) Algoritmos propios + APIs de datos de terceros (como Google PageSpeed Insights API); 2) Integración pura de servicios de terceros (como combinaciones SEMrush/Lighthouse); 3) Modelo híbrido (indicadores centrales propios + adquisición de datos de cola larga). El modelo híbrido ofrece el mejor equilibrio entre costo y precisión, representando el 58% del mercado (Fuente: Estudio de funciones CMS 2023).

Tomemos como ejemplo el sistema de construcción de sitios inteligentes Yizhuangbao: su herramienta de detección AI adopta un modelo híbrido, analizando densidad de palabras clave TDK con algoritmos NLP propios (alineados con principios Google E-A-T), mientras integra nodos de datos RUM en 7 continentes para monitorear rendimiento de usuarios reales. Para empresas con requisitos duales de conformidad multilingüe y SEO localizado, esta solución puede reducir un 35% el trabajo manual de verificación cruzada. Nota: su módulo de detección de materiales publicitarios aún no admite plataformas emergentes como TikTok, requiriendo desarrollo secundario de API.

- Verifique primero si las herramientas distinguen entre "indicadores técnicos" (como LCP ≤2.5s) e "indicadores comerciales" (como aumento de consultas por cada punto SEO ganado)

- Exija a proveedores al menos 3 casos reales de optimización de clientes similares (incluyendo datos antes/después de optimización)

- Proyectos globales deben verificar cobertura de requisitos especiales de mercados objetivos (como sistema de puntuación TIC de Yandex en Rusia)

Se recomienda pruebas comparativas en entornos sandbox: usar diferentes herramientas para detectar la misma página simultáneamente, observando si las diferencias exceden márgenes de error industriales (±8% para detección de rendimiento técnico, ±15% para puntuaciones SEO).

En escenarios de construcción de sitios de comercio electrónico transfronterizo, lo que realmente necesita verificación prioritaria no son valores absolutos en informes de detección, sino la correspondencia entre metodologías de recolección de datos de la herramienta y reglas de motores de búsqueda en mercados objetivos.

- Yiwu Treasure

- Plataforma de construcción de sitios web

- SEO

- Sitio independiente

- Sistema de construcción de sitios web inteligente

- SEO multilingüe

- TikTok

- Detección de sitios web

- Diagnóstico SEO

- Sitios independientes multilingües

- Creación de sitios web inteligentes

- Yisoubao creación de sitios web inteligentes

- Creación de sitios web de comercio transfronterizo

- Herramientas de creación de sitios web

- Comercio electrónico transfronterizo

Artículos relacionados

![¿Cómo evitar los errores al utilizar proyectos de startups sin código? Cuatro errores comunes cometidos por los usuarios finales en 2026. ¿Cómo evitar los errores al utilizar proyectos de startups sin código? Cuatro errores comunes cometidos por los usuarios finales en 2026.]() ¿Cómo evitar los errores al utilizar proyectos de startups sin código? Cuatro errores comunes cometidos por los usuarios finales en 2026.

¿Cómo evitar los errores al utilizar proyectos de startups sin código? Cuatro errores comunes cometidos por los usuarios finales en 2026.![¿Cómo seleccionar un agente exclusivo para sitios web de comercio exterior? Cinco dimensiones clave para evaluar el cumplimiento normativo y lista de verificación para evitar errores en 2026. ¿Cómo seleccionar un agente exclusivo para sitios web de comercio exterior? Cinco dimensiones clave para evaluar el cumplimiento normativo y lista de verificación para evitar errores en 2026.]() ¿Cómo seleccionar un agente exclusivo para sitios web de comercio exterior? Cinco dimensiones clave para evaluar el cumplimiento normativo y lista de verificación para evitar errores en 2026.

¿Cómo seleccionar un agente exclusivo para sitios web de comercio exterior? Cinco dimensiones clave para evaluar el cumplimiento normativo y lista de verificación para evitar errores en 2026.![¿Qué es la aceleración global de CDN? — Un análisis en profundidad de los principios esenciales de aceleración subyacentes para las empresas que se internacionalizarán para 2026. ¿Qué es la aceleración global de CDN? — Un análisis en profundidad de los principios esenciales de aceleración subyacentes para las empresas que se internacionalizarán para 2026.]() ¿Qué es la aceleración global de CDN? — Un análisis en profundidad de los principios esenciales de aceleración subyacentes para las empresas que se internacionalizarán para 2026.

¿Qué es la aceleración global de CDN? — Un análisis en profundidad de los principios esenciales de aceleración subyacentes para las empresas que se internacionalizarán para 2026.

Productos relacionados