- 외贸 웹사이트 소셜 미디어 자동화 랜딩 페이지의 어려움은 어디에 있나요? 상하이 서비스 업체가 특정 자동차 부품 브랜드를 위해 포르투갈어 지역 소셜 미디어 일일 업데이트 + 문의 47% 증가 달성2026-02-06자세히 보기

- 상하이 외국어 웹사이트 공급업체 추천 목록2026-02-06자세히 보기

- Yandex SEO 최적화 어디가 좋을까? 광주 현지 서비스 업체 반응 속도, 러시아어 콘텐츠 생산 능력과 규정 준수 실측2026-02-07자세히 보기

- 포르투갈어 독립 사이트 구축 서비스 제공업체의 응답 시간 기준 충족 여부? 7개 업체의 애프터서비스 SLA 이행률 테스트 결과2026-02-05자세히 보기

- 왜 92%의 B2B 무역 기업이 이영보 SAAS 웹사이트 구축을 선택할까요? 2024년 서비스 제공업체 안정성 조사 데이터2026-02-05자세히 보기

- B2B 무역 기업 자체 구축 사이트 vs 이영보 SAAS 구축: 첫해 종합 비용 및 ROI 계산표2026-02-05자세히 보기

- 2024년 포르투갈어 독립 사이트 구축 플랫폼 어떻게 선택할까? 3대 주요 서비스 업체의 비용과 납품 주기 비교2026-02-05자세히 보기

- 유통업체 선정 참고: 베이징 아랍어 독립 사이트 구축 업체가 화이트 라벨 + 다중 단말기 브랜드 맞춤 설정을 지원할 수 있나요?2026-02-05자세히 보기

웹사이트 개발에서 로봇을 사용하는 방법

웹사이트에서 robots.txt 파일을 사용하면 검색 엔진 크롤러가 웹사이트 콘텐츠에 접근하는 것을 제어할 수 있습니다. 웹사이트에서 robots.txt를 사용하는 방법에 대한 자세한 단계와 주의 사항은 다음과 같습니다.

1. robots.txt 파일을 만듭니다.

텍스트 편집기 사용: 텍스트 편집기(예: Notepad++, Sublime Text 또는 일반 메모장)를 열고 robots.txt 파일의 내용을 작성할 준비를 합니다.

규칙 작성: 웹사이트의 필요에 따라 해당 규칙을 작성합니다. 일반적으로 이러한 규칙에는 어떤 검색 엔진 크롤러(User-agent)가 어떤 URL 경로에 접근할 수 있는지(Allow) 또는 금지하는지(Disallow) 지정하는 것이 포함됩니다.

파일 저장: robots.txt라는 이름으로 파일을 저장하고, 파일 확장자는 .txt, 파일 이름은 모두 소문자로 작성해야 합니다. 또한, 다른 서버나 브라우저에서 글자가 깨지는 현상을 방지하기 위해 파일이 UTF-8로 인코딩되었는지 확인하세요.

2. robots.txt 파일을 넣으세요

웹사이트 루트 디렉터리에 업로드: FTP 소프트웨어나 웹사이트 백엔드 관리 인터페이스를 사용하여 robots.txt 파일을 웹사이트 루트 디렉터리에 업로드하세요. 예를 들어, 웹사이트 도메인 이름이 www.example.com인 경우, robots.txt 파일은 http://www.example.com/robots.txt에 있어야 합니다.

웹사이트가 온라인 상태가 되면 시스템이 자동으로 robots 파일을 생성합니다. robots.txt 파일의 URL은 다음과 같습니다. domain name/robots.txt;

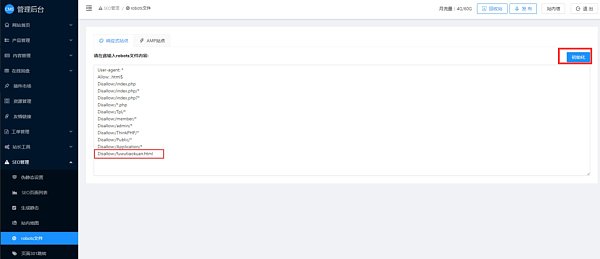

로봇 파일을 사용자 지정해야 하는 경우 CMS 관리 백엔드 - SEO 관리 - 로봇 파일에서 수정할 수 있습니다. 사용자 지정 후 시스템 기본 로봇 파일로 되돌리려면 오른쪽의 초기화 버튼을 클릭하여 시스템 기본 로봇 파일 내용을 복원할 수 있습니다. 수정 후 저장하고 게시하세요.

예를 들어, 웹사이트의 특정 페이지가 포함되지 않기를 원하는 경우(페이지 링크가 https://www.abc.com/fuwutiaokuan.html인 경우) 해당 페이지가 포함되지 않기를 원하는 경우 아래와 같이 robots 파일 콘텐츠에 도메인 이름/ 뒤에 있는 부분을 추가하면 됩니다.

3. robots.txt 규칙 작성

robots.txt 파일의 내용은 주로 일련의 사용자 에이전트와 지침(예: Disallow, Allow)으로 구성됩니다. 다음은 몇 가지 기본 규칙과 예시입니다.

User-agent: 규칙이 적용되는 검색 엔진 크롤러를 지정합니다. 예를 들어, User-agent: *는 규칙이 모든 크롤러에 적용됨을 의미하고, User-agent: Googlebot은 규칙이 Google 크롤러에만 적용됨을 의미합니다.

Disallow: 접근을 허용하지 않을 URL 경로를 지정합니다. 예를 들어, Disallow: /admin/은 /admin/ 디렉터리와 그 하위 디렉터리 및 웹사이트 루트 디렉터리 아래의 파일에 대한 접근을 금지한다는 의미입니다.

Allow(선택 사항): Disallow의 반대 개념으로, 접근이 허용되는 URL 경로를 지정합니다. 모든 검색 엔진이 Allow 지시어를 지원하는 것은 아니며, 일반적으로 Disallow 지시어와 함께 사용하여 더욱 정교한 제어를 제공합니다.

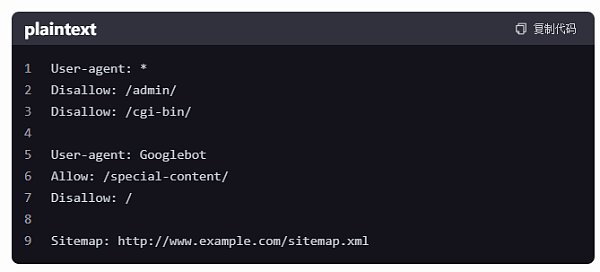

예

이 예에서는:

모든 크롤러는 /admin/ 및 /cgi-bin/ 디렉토리에 접근하는 것이 금지되어 있습니다.

Googlebot은 /special-content/ 디렉토리에는 접근할 수 있지만, 사이트의 나머지 부분에는 접근할 수 없습니다(참고: Disallow: /는 Allow 뒤에 옵니다. Allow는 검색 엔진이 Allow 명령어를 지원하고 이 상황을 올바르게 처리하지 않는 한 이전 Allow 명령어보다 우선합니다). 그러나 이는 단지 예시일 뿐이며, 실제 사용 시에는 이러한 충돌을 피하기 위해 조정이 필요할 수 있습니다.

사이트맵 지침은 검색 엔진이 사이트 구조를 더 잘 이해하는 데 도움이 되는 사이트맵의 URL을 제공합니다.

5. 노트

파일 이름과 위치가 올바른지 확인하세요. robots.txt 파일은 웹사이트의 루트 디렉토리에 있어야 하며 파일 이름은 모두 소문자여야 합니다.

규칙을 작성할 때는 주의하세요. 잘못된 규칙으로 인해 중요한 페이지가 검색 엔진에서 무시되거나 삭제될 수 있으며, 이는 웹사이트의 SEO 효과에 영향을 미칩니다.

정기적인 검토 및 업데이트: 웹사이트 콘텐츠가 업데이트되고 변경되면 robots.txt 파일을 정기적으로 검토하고 업데이트하여 웹사이트의 요구 사항을 계속 충족하는지 확인해야 할 수 있습니다.

검색 엔진 지원을 이해하세요. 검색 엔진마다 robots.txt 파일에 대한 지원 수준이 다를 수 있으므로 규칙을 작성할 때 이를 고려해야 합니다.

도구 감지 사용: 다양한 온라인 도구를 사용하여 robots.txt 파일의 구문과 논리가 올바른지 감지하여 검색 엔진이 이러한 규칙을 올바르게 이해하고 적용할 수 있는지 확인할 수 있습니다.

해외 무역 웹사이트 구축 및 운영에 관한 문의사항이 있으시면, Eyingbao 기술 고객센터 WeChat: Ieyingbao18661939702로 문의해주세요. 담당 직원이 성심껏 답변해드리겠습니다!

사진 자료는 인터넷에서 가져온 것입니다. 저작권 침해가 있을 경우 400-655-2477로 연락해 주세요.

관련 기사

관련 제품